robots.txt

Categories:

robot.txt 說明

使用robots.txt限制搜尋引擎對無需檢索的部分進行檢索

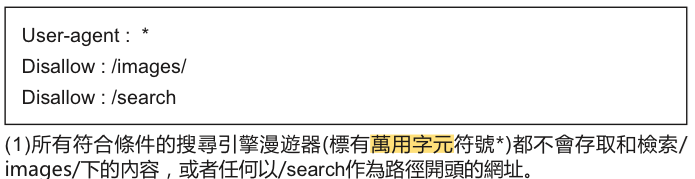

「robots.txt」檔案可告知搜尋引擎是否可以存取您網站的某些部分,進而對這些部分進行檢索 (1)。

這個檔案必須命名為「robots.txt」,並放置在您網站的根目錄中(2)。

您可能不希望搜尋引擎檢索網站中的某些網頁,因為這些出現在搜尋結果中的網頁,對使用者而言並無益處。如果您確實想阻止搜尋引擎檢索您的網頁,「Google網站管理員工具」中有一個很好用的 robots.txt 產生器,可協助您建立這個檔案。請注意,如果您的網站使用了子網域,且您不希望搜尋引擎檢索特定子網域中的某些網頁,則您必須為該子網域建立一個單獨的 robots.txt 檔案。如需更多有關 robots.txt 的資訊,我們建議您參閱有關使用 robots.txt 檔案的「網站管理員說明中心」指南。

另有幾種方法可以避免您的內容出現在搜尋結果中,例如為您的 robots 中繼標記新增「NOINDEX」、使用 .htaccess 對目錄進行密碼保護,以及使用「Google網站管理員工具」移除已檢索的內容。Google工程師 MattCutts 在一部實用影片中詳細解說了每種網址封鎖方法的注意事項。

名詞解釋

漫遊器排除標準

避免讓網路自動尋檢程式 / 檢索器 (例如 Googlebot) 存取網站全部內容或部分內容的慣例,允許的話則會讓內容公開曝光。

Proxy服務

內部網路和外部網路都在連線中的行況下,取代連線功能的電腦或軟體。

robot.txt做法

對敏感的內容使用更為安全的方法

您或許對使用 robots.txt 來封鎖敏感或機密資料感覺不是特別放心。其中一個原因是,如果網際網路上碰巧存在連至您封鎖網址的連結 (例如參照記錄),則搜尋引擎仍然可以參照該網址 (只是顯示網址,而不顯示標題或摘要)。

此外,一些不符合條件的搜尋引擎或惡意搜尋引擎並不遵守「漫遊器排除標準」,可能會違背您的 robots.txt 指示。最後,好奇的使用者可能會查看您 robots.txt 檔案中的目錄或子目錄,並猜中您不想曝光的內容網址。對內容加密或使用 .htaccess 對內容進行密碼保護是更安全的選擇。

請避免 :

允許檢索類似搜尋結果的網頁(使用者不喜歡從一個搜尋結果網頁進入另一個搜尋結果網頁,這對他們而言沒有多大價值)

允許檢索大量自動產生的且內容相同或稍有不同的網頁:「難道這100,000個近乎相同的網頁真的應該在搜尋引擎的索引中出現嗎?」

允許檢索因Proxy服務而建立的網址